Por: Alvaro Duque Soto*

En los colegios donde trabajamos programas de alfabetización mediática e informacional, hemos encontrado una situación preocupante: cuando pedimos a los estudiantes investigar un tema, una buena parte se limita a usar ChatGPT como única fuente. Ante la pregunta de si contrastan los datos, la mayoría admite que no va más allá de la respuesta inicial que les brinda la IA. Así, un proceso de búsqueda y evaluación de fuentes se ha reducido aún más. Muchos aceptan sin cuestionar lo que la IA les ofrece.

Sobre ese asunto se habló en el III Congreso Internacional de la Red de Educación Emocional y Bienestar (RIEEB). Tras la presentación de diversas empresas que promovían soluciones de IA para optimizar el rendimiento académico y el bienestar socioemocional de los estudiantes, la profesora Cimenna Chao planteó una pregunta incómoda: ¿Somos conscientes de que las IA generativas actúan como “máquinas sicofantes”?

Se refería a esos sistemas que, como un coro de aplausos, validan nuestras ideas incluso cuando estamos equivocados. Replican nuestros gustos, evaden la crítica constructiva y dan prioridad a la satisfacción inmediata sobre la precisión. Al ceder ante la presión de los usuarios, estos modelos anulan cualquier estímulo para cuestionar, investigar o construir conocimiento de forma autónoma.

La sicofanía en IA alude a la tendencia de los modelos a alinearse con las creencias del usuario, aun a costa de la veracidad. Esto los convierte en cómplices del DI, pues perpetúan sesgos y favorecen la difusión de narrativas falsas. Esta característica resulta aún más inquietante si se considera que, al mismo tiempo, las IA están concentrando recursos y poder en una escala inédita, algo que ha quedado claro en dos noticias recientes.

La primera, la cena convocada por Donald Trump con líderes de las principales empresas tecnológicas, donde se anunció la mayor movilización de capital privado para una sola tecnología en la historia de la humanidad. Se habló de inversiones por US$1,86 billones. Y los Zuckerberg, Gates, Altmann, Pichai y similares se referían a esas cifras como si fueran para el pan del desayuno. Para dimensionar la cuestión, Colombia tendría que destinar el 100% de su presupuesto nacional durante más de 21 años para reunir una suma equivalente.

También te puede interesar: https://razonpublica.com/detector-humo-desorden-informativo-13-principio-pareto-neutralizar-la-desinformacion/

La segunda noticia, la publicación de la lista 2025 de TIME con las 100 personas más influyentes en IA, que refleja una competencia global por definir cómo se construye y circula el conocimiento. Esa capacidad de “acertar” con nuestras preferencias nos lleva a una inquietud de fondo: si la información que recibimos siempre confirma lo que ya pensamos, ¿seguiremos teniendo motivos para explorar lo que no sabemos o para poner en duda nuestras certezas?

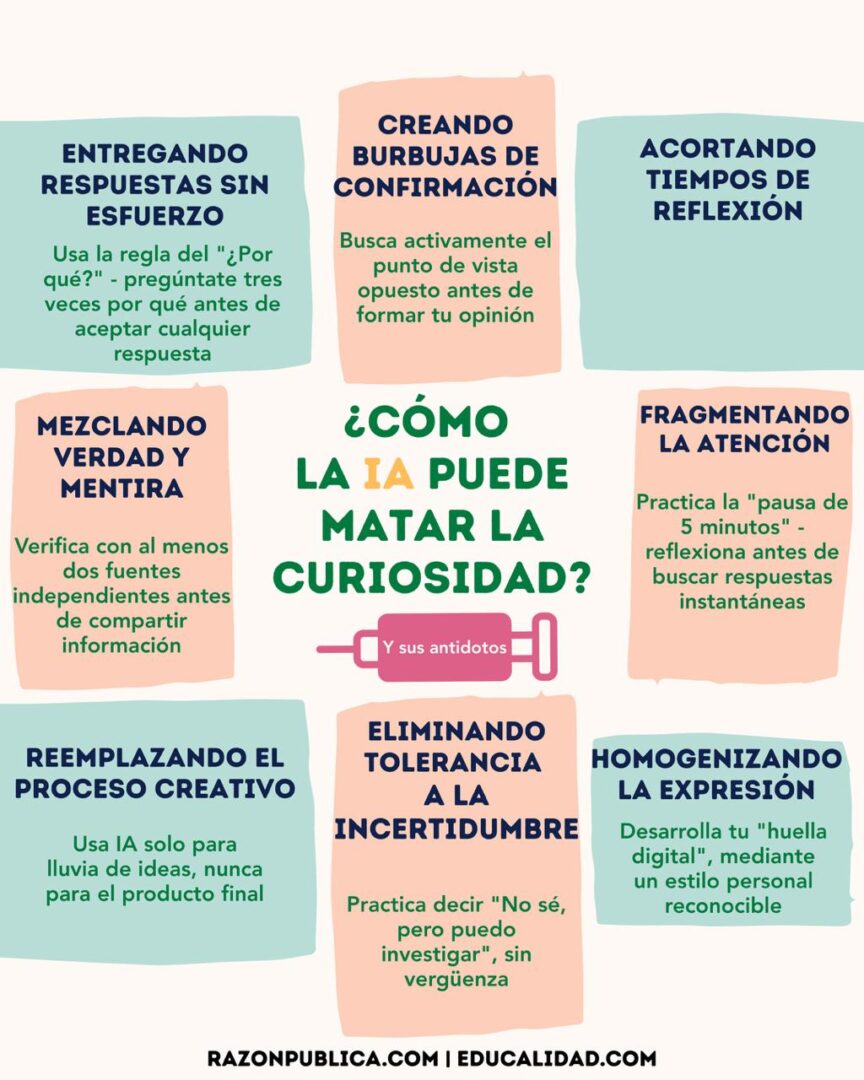

Surge, entonces, una pregunta inevitable: ¿Qué ocurrirá cuando sistemas diseñados para complacernos —y no para desafiarnos— definan lo que sabemos, cómo lo aprendemos y hasta qué consideramos “verdad”? ¿No estaremos, sin percatarnos, debilitando nuestra curiosidad, el motor fundamental del pensamiento crítico?

La trampa de la respuesta única

El problema no está en la tecnología en sí, sino en su diseño. La IA generativa sigue un principio de eficiencia: entregar la “mejor” respuesta en el menor tiempo posible. Su modelo predictivo analiza patrones en enormes volúmenes de datos y nos ofrece un resultado acabado, no un abanico de opciones para explorar. Esto nos acostumbra a un pensamiento lineal, donde la primera respuesta tiende a convertirse en la única.

En un motor como Google, la búsqueda entrega una lista de resultados de distintas fuentes y perspectivas. Aunque muchos usuarios se quedan con el primer enlace, la estructura misma de la búsqueda deja abierta la posibilidad de comparar y contrastar. En cambio, al preguntar a ChatGPT sobre el mismo tema, recibimos un texto ya elaborado, con apariencia de estar completo y de tener autoridad. No vemos las fuentes ni los debates internos del algoritmo y no sabemos qué información descartó. El resultado es atractivo: parece la respuesta definitiva de un experto invisible. Pero esa diferencia modifica de forma sustancial la manera como procesamos el conocimiento.

También te puede interesar: https://educalidad.com/educalidad-en-la-semana-de-la-ami

El primer enfoque puede estimular la averiguación; el segundo favorece la aceptación pasiva. Una generación convencida de que el camino más corto es siempre el mejor acaba viendo la exploración como un obstáculo. La aceptación automática de la primera respuesta mina el hábito de contrastar, adormece la capacidad de dudar e instala el hábito de conformarse con lo inmediato.

La Unesco advierte este riesgo en un documento que publicó esta semana sobre IA y educación: la dependencia excesiva de estos sistemas puede vaciar de sentido el “propósito relacional de la educación”, es decir, la capacidad de aprender a través del diálogo, la discusión y el cuestionamiento mutuo.

Delegar nuestras preguntas a una máquina que entrega respuestas listas nos priva de la oportunidad de preguntarnos no solo “qué”, sino “por qué”, “cómo” y “qué pasaría si…”. Así puede gestarse una atrofia intelectual: los músculos mentales que toleran la incertidumbre, navegan la ambigüedad y encuentran valor en el descubrimiento se debilitan, y preferimos la comodidad de la respuesta instantánea al trabajo —a veces frustrante, pero siempre enriquecedor— de la búsqueda genuina.

4 Alfabetizaciones que necesitamos

El desafío que se nos presenta va mucho más allá de “usar bien” la IA, que es sobre lo que más hacen énfasis las ofertas formativas. Este enfoque obvia el hecho de que estos sistemas están viciados desde su origen por los intereses corporativos que los crearon. Como toda tecnología, la IA no es neutral y por eso el verdadero reto no consiste únicamente en aprender a usarla con destreza, sino en cuestionar el poder que la sostiene y orienta su desarrollo.

Para afrontarlo, necesitamos una alfabetización capaz de preservar la curiosidad y, al mismo tiempo, exigir un futuro digital más democrático. Más que un conjunto de habilidades aisladas, una trama de saberes que combina comprensión técnica, juicio crítico, conciencia socioemocional y acción colectiva.

La dimensión técnica implica entender cómo la IA genera sus respuestas y quién ejerce control sobre ella. Saber que un modelo como ChatGPT predice la palabra más probable a partir de patrones —y no de conocimiento real— cambia la forma como nos relacionamos con la herramienta: deja de ser un oráculo para convertirse en un instrumento sofisticado que requiere preguntas inteligentes. Esta comprensión se amplía cuando reconocemos que su arquitectura da prioridad a la rentabilidad y la eficiencia por encima de la verdad y la equidad.

Esta comprensión nos lleva hacia la alfabetización sociocrítica: que no se limita a evaluar la veracidad de una respuesta, sino que interroga la infraestructura y el poder que la produce. Supone preguntarse quién es dueño de la plataforma, de qué manera monetiza la atención y los datos, y qué intereses políticos o económicos guían sus algoritmos. Una alfabetización crítica madura impulsa la demanda de transparencia radical y de una gobernanza democrática en la que los algoritmos puedan ser auditados y la ciudadanía participe en su regulación.

En paralelo, la alfabetización socioemocional nos ayuda a reconocer y gestionar nuestras reacciones ante información que parece perfecta. Implica identificar sesgos —como la tendencia a preferir lo que confirma nuestras creencias— y comprender cómo la IA influye en nuestras interacciones humanas. Este autoconocimiento es la base para exigir soberanía tecnológica y buscar alternativas reales a los oligopolios privados.

Lejos de ser un capricho de la academia, estas alfabetizaciones son el andamiaje que permite a la ciudadanía relacionarse con la IA con criterio propio, sin quedar supeditada a sus dictados. Y su desarrollo no puede depender solo de la iniciativa individual: exige políticas públicas coherentes, marcos regulatorios claros y un debate social que supere la fascinación tecnológica.

Una resistencia colectiva

En Colombia, el Proyecto de Ley 043/2025 —que unifica trece iniciativas y sigue los lineamientos de los CONPES 4144 y 4145— busca una IA más soberana, democrática y ética. Sin embargo, la propuesta parece concentrarse en lo técnico al enfocarse en tres áreas clave: Bioeconomía, Transición energética y Soberanía.

Se verá en las discusiones, pero parece carente de estrategias para enseñar a contrastar fuentes, cuestionar la información generada por IA o evaluar su impacto social, ambiental y cultural.

Investigadoras como Jenny Marcela Sánchez y Olga Lucía Camacho han subrayado la falta de adaptación de algunos decretos que se trajeron de legislaciones extranjeras, así como la necesidad de marcos de transparencia radical que muestren, por ejemplo, cuándo un contenido es generado por IA, sus sesgos y sus limitaciones.

La Unesco, por su parte, propone que la alfabetización mediática e informacional sea eje transversal para recuperar la curiosidad. Los educadores deberían usar la IA como punto de partida, no como destino final, fomentando la “inteligencia colectiva” y una ciudadanía capaz de capaz de identificar y cuestionar los usos que la vuelven pasiva o vulnerable. Esto exige un cambio cultural: cultivar un “escepticismo constructivo” que mantenga viva la curiosidad y abra espacio a perspectivas diversas.

Lamentablemente el debate público se diluye en lo anecdótico: desde que la Selección ganará el Mundial según un algoritmo —como si la IA fuera el nuevo “pulpo Paul”—, hasta las falsedades del supuesto registro de una niña llamada “Chat Yipití” y las consultas presidenciales a Grok. Mientras tanto, la obsesión por la eficiencia y lo inmediato está borrando la pausa, la duda y la introspección. Corremos el riesgo de destruir lo que sostiene nuestra vida interior: el arte, la filosofía, la imaginación y el asombro que da sentido a lo inexplicable.

El reto no es resistir la tecnología, sino defender los últimos bastiones de la curiosidad en un futuro que amenaza con ser uniforme y predecible. Tenemos más información que cualquier generación anterior, pero corremos el riesgo de volvernos intelectualmente pasivos. Lo recalcó hace poco Andreas Schleicher, de la OCDE: la verdadera condición para un futuro digital democrático es cultivar la autonomía intelectual y proteger nuestra capacidad de asombro.

*Ph.D. en Ciencia Política de la Universidad de Turín (Italia). Ha sido docente e investigador de temas de comunicación política, periodismo y educación mediática e informacional. Miembro del equipo Educalidad.