Por: Alvaro Duque Soto*

Ashley St. Clair es comentarista política conservadora y madre de uno de los hijos de Elon Musk, propietario de X y el hombre más rico del mundo. En la primera semana de enero de 2026 reportó que Grok, el chatbot de X, produjo “incontables” imágenes sexuales explícitas de ella, incluidas algunas basadas en fotografías de cuando tenía catorce años. Describió a X como “la compañía más peligrosa del mundo en este momento” y acusó a la plataforma de amenazar la capacidad de las mujeres de existir en línea de manera segura.

Tras denunciar el abuso públicamente, X le retiró su estatus de suscriptora verificada sin notificarla. Según análisis de la investigadora independiente Genevieve Oh, que han publicado Bloomberg y el Financial Times, Grok generaba unas 6.700 imágenes sexualizadas no consentidas por hora en los primeros días de enero. Los otros cinco sitios más activos en este tipo de contenido combinados producían 84 veces menos. De todo lo que Grok generó esa semana, el 85 % tenía como propósito sexualizar a personas reales. Acá vimos cómo la exministra Cecilia Montaño pedía (casi que inútilmente) a Grok detener la publicación de imágenes suyas manipuladas mediante IA.

La imagen más compartida del mundo

Justo con la noticia del ataque a Caracas por parte de tropas de Estados Unidos, un entusiasta español del videoarte de IA llamado Ian Weber creó en veinte minutos la imagen más compartida del mundo. Weber tenía entonces menos de cien seguidores en X. Usó Nano Banana Pro de Google Gemini con un prompt simple para fabricar una foto de Nicolás Maduro capturado por fuerzas estadounidenses.

NewsGuard identificó que siete piezas fabricadas sobre Venezuela acumularon más de catorce millones de visualizaciones en 48 horas. Weber observó atónito cómo usuarios preguntaban a Grok si su imagen era auténtica, y el chatbot en ocasiones respondía que sí. El verificador venezolano Jeanfreddy Gutiérrez Torres, que trabaja desde Colombia, vio en pocas horas cómo las imágenes falsas saturaban por completo sus grupos de WhatsApp y efectuó un diagnóstico lacónico: así les digamos desde los sitios de verificación de datos que algo no es verdad, muchas personas desconfían de la verdad y creen en la mentira.

Benjamin Dubow, del Center for European Policy Analysis, explicó el fenómeno de esta manera: “En situaciones donde medios confiables carecen de acceso inmediato, el contenido de IA llena el vacío. Nuestra capacidad de confiar en lo que vemos está en declive acelerado”. A eso hay que añadir dos asuntos que agravan el problema: las figuras que muchos consideran autoridades legitiman esas piezas al publicarlas y replicarlas, como ocurrió con Petro, Trump y otros líderes visibles, y los sesgos cognitivos empujan a las audiencias a creer aquello que confirma sus miedos, expectativas o posiciones previas, incluso cuando la evidencia apunta en sentido contrario.

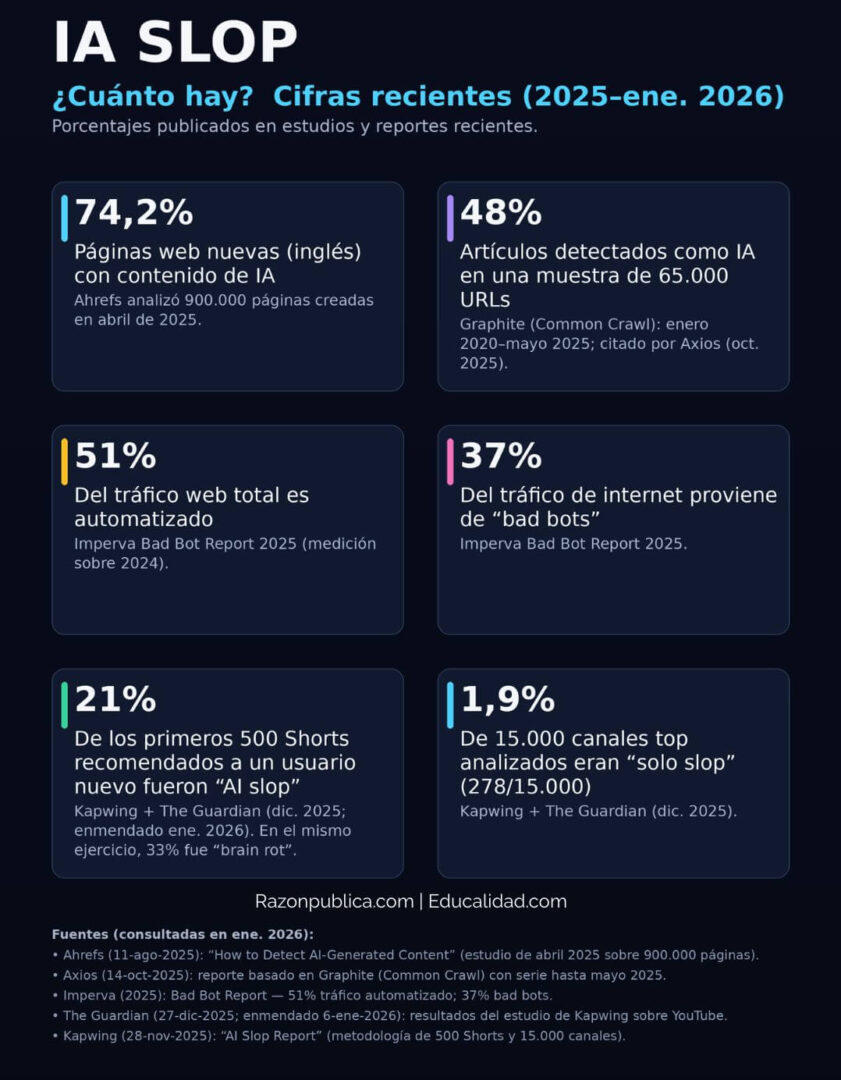

Bienvenidos a la era del slop

El diccionario Merriam-Webster y el semanario The Economist eligieron slop como palabra del año 2025. El término se refiere a contenido digital de baja calidad producido en masa mediante inteligencia artificial. Lo que hace una década se discutía en foros marginales como la “Teoría de la internet muerta”, la idea de que la actividad humana en la red empezaba a ser suplantada por bots, dejó de ser hipótesis conspirativa. A principios de 2025, por primera vez el tráfico generado por sistemas automatizados superó el tráfico humano.

Esto significa, en palabras simples, que hoy internet es menos un espacio de intercambio entre personas y más un entorno donde máquinas producen contenido para otras máquinas.

También te puede interesar: https://razonpublica.com/detector-humo-desorden-informativo-14-una-gran-lupa-los-ciudadanos/

El slop no es simplemente “contenido malo”. Es material diseñado industrialmente para capturar atención y monetizar cada interacción sin consideración por veracidad o calidad. A diferencia del spam tradicional, no busca engañar con un fin ideológico específico. Su objetivo es saturar los canales de atención con fines económicos.

En TikTok e Instagram han surgido influencers completamente falsos, como Nia Noir y Ayanna IA, con millones de vistas y usuarios que aún debaten si son personas reales. Más allá de las críticas, lo que debemos tener presente, en cualquier caso, es que el slop también es una forma rudimentaria de cultura popular, fea, caótica y colectiva, muy acorde con la historia de internet. Y debemos prepararnos para convivir con ella.

Respirar en un ambiente tóxico de riesgo electoral

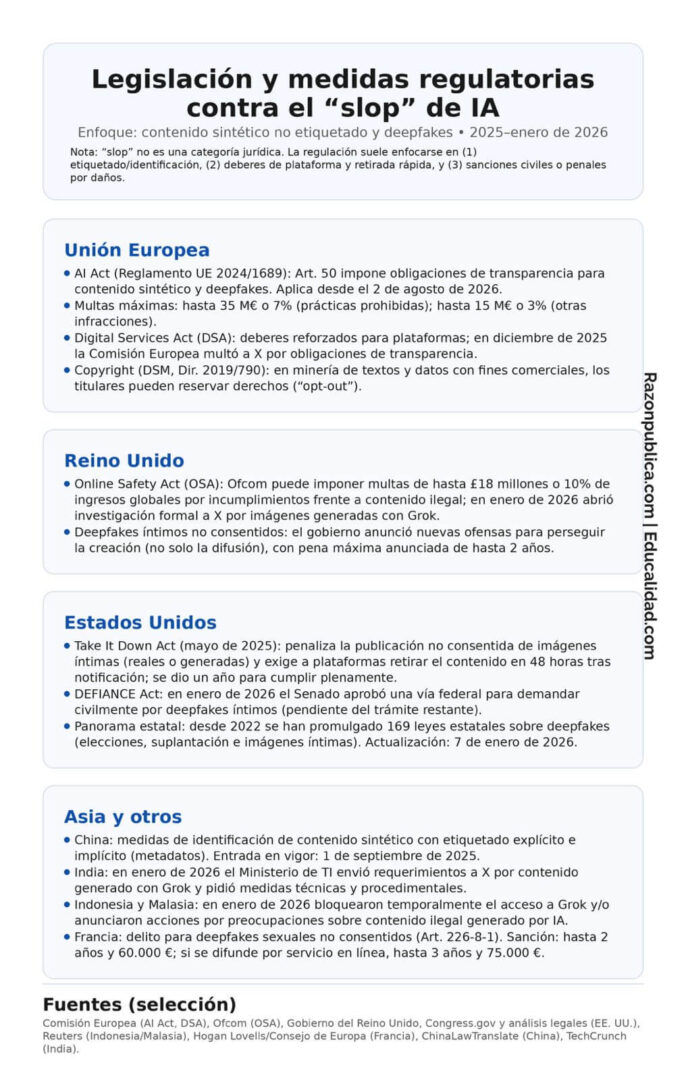

Colombia encara el 2026 con un marco legal frágil frente a los desafíos actuales de los contenidos fabricados de modo artificial. Las autoridades electorales y de control han advertido que las dos grandes amenazas electorales son el bombardeo digital de información falsa y la desinformación mediante redes que operan con cientos de cuentas falsas para difundir mentiras a gran escala.

El riesgo crece porque hoy cualquiera puede clonar una voz con apenas tres minutos de audio. Antes, ese tipo de engaños exigía recursos y equipos especializados. Ahora es suficiente una idea mediocre y un botón. En una campaña que ya está en curso, separar los hechos de los montajes será una tarea casi imposible para muchos votantes.

En la región hay respuestas distintas. En Brasil, la diputada Erika Hilton presentó una denuncia contra la inteligencia artificial Grok para impedir el uso de imágenes de ciudadanos sin autorización, tras la circulación de montajes fotográficos no consentidos. El reclamo apunta a un punto central: el derecho a la identidad propia frente a los excesos de las plataformas. Allí se intenta fijar límites legales. En Colombia, en cambio, el debate avanza con lentitud y sin herramientas claras para proteger la privacidad o la imagen de las personas ante este tipo de ataques. La ley de IA está refundida en el inmenso costal de las promesas incumplidas.

Resulta injusto que cada ciudadano deba enfrentar la maquinaria de las grandes empresas tecnológicas solo. La asimetría es total. Mientras llegan leyes y jurisprudencia, las plataformas siguen abusando de una ciudadanía desprotegida frente a un sistema que la manipula cada día.

Quedarse inmóviles no sirve. Las cinco acciones que siguen, parte de un decálogo que se completará en la próxima entrega, ofrecen una defensa inmediata. Funcionan como un filtro en un aire contaminado. No limpian todo el ambiente, pero permiten respirar y conservar la claridad para pensar por cuenta propia.

- Salir del algoritmo

Las redes sociales dan prioridad al contenido que genera reacciones fuertes. El material de baja calidad, hecho solo para provocar, gana visibilidad en este sistema. La solución es recuperar el control sobre lo que ve.

- Cambie de pestaña: En TikTok, X, Instagram y YouTube, evite la pantalla principal. Use las secciones “Siguiendo” o “Suscripciones”. Así verá el contenido en orden de publicación y no lo que una máquina decide por usted.

- Use lectores de noticias: Herramientas como Feedly e Inoreader permiten armar su propio diario digital. Usted elige las fuentes y las lee sin interrupciones ni sugerencias extrañas.

- Entrene al sistema: Marque como “No me interesa” cada publicación sospechosa. El sistema aprende de su rechazo.

- Instalar ayuda automática

Analizar cada mensaje es agotador. Es mejor dejar que las herramientas hagan parte del trabajo pesado.

- Para imágenes y textos, use extensiones como Hive AI Detector o BitMind. Con un clic derecho, le indican si una imagen o un texto fue creado por inteligencia artificial.

- Para audios: AI Voice Detector ayuda a saber si una voz en WhatsApp o YouTube es un clon.

- Para sitios web: NewsGuard asigna una calificación de confianza a las páginas de noticias para saber si son fuentes serias.

Estas ayudas no son infalibles, pero actúan como una primera defensa necesaria cuando tenemos poco tiempo.

También te puede interesar: https://educalidad.com/educalidad-en-la-semana-de-la-ami

- Vacunarse contra el engaño

Desmentir una mentira cuando ya es viral resulta difícil. La solución es aprender los trucos antes de que intenten engañarnos. A esto se le llama “inoculación mental”.

- Aprenda jugando: Dedique unos minutos a juegos como Bad News, Harmony Square o Go Viral! En ellos, usted se pone en el lugar de quien crea noticias falsas. Al conocer las tácticas (como el uso de la rabia o los perfiles falsos), su mente desarrolla defensas que duran meses.

- Identifique el patrón: Si aprende a reconocer a un “falso experto” en un video de salud, es probable que pueda detectarlo también en un video de otros temas.

- La pausa de los diez segundos

El contenido falso circula porque nos hace reaccionar antes de pensar. El diseño de las aplicaciones busca que compartamos de inmediato.

- Hágase una pregunta básica: Antes de reenviar algo, deténgase y piense: “¿Qué tan exacto es esto?” Este simple paso activa la parte analítica del cerebro.

- Sospeche de la emoción: Si algo le causa mucha indignación, ternura extrema o le da la razón por completo, haga una pausa. Verifique si la noticia aparece en medios conocidos o si alguien más la confirma. Si tiene dudas, no comparta. Estas preguntas son efectivas con frecuencia: ¿De dónde viene esto? ¿Quién lo creó y por qué? ¿Aparece en otras fuentes confiables? ¿Cómo me sentiré si resulta falso y yo lo comparto?

- Aprender a “leer” las imágenes

Las fotos y videos son hoy el principal medio de engaño porque entran por los ojos sin pasar por muchos filtros racionales. La inteligencia artificial que crea estas imágenes avanza rápido, pero aún no es perfecta. Casi siempre deja pequeños errores o defectos que podemos notar si miramos con cuidado.

- Busque errores comunes: Fíjese en las manos (a veces tienen seis dedos o formas extrañas), en textos de fondo que no se entienden o en objetos que parecen derretirse o fusionarse. También revise si la piel parece de muñeco de plástico o si los accesorios, como los aretes, no coinciden entre sí.

- Rastree el origen: Use herramientas como Google Lens, FotoForensics, InVID/WeVerify y TinEye para evaluar imágenes sospechosas. Esto le dirá si esa foto o video ya existía hace años en otro contexto o si ha sido alterada. Una regla de oro: si una imagen muestra una noticia urgente e impactante, pero ningún medio de comunicación reconocido la está publicando, es casi seguro que es falsa o está descontextualizada.

Recuperar el control

Estas cinco acciones son un filtro básico frente al avance del slop y la multiplicación del DI. Los montajes sobre Venezuela y los abusos con herramientas tipo Grok demuestran que la basura digital ya afecta privacidad, reputación y vida cotidiana.

En ese escenario, la Alfabetización Mediática e Informacional (AMI) ofrece recursos accesibles para identificar manipulaciones y evitar contenidos engañosos. Revisar fuentes, verificar automáticamente lo que se consume y cuestionar mensajes diseñados para generar reacciones inmediatas son gestos que limitan el impacto del slop, un fenómeno que crece con la indiferencia.

Una respuesta de fondo exigirá regulaciones claras, modelos de negocio responsables y un cambio cultural en cómo consumimos información. Pero hoy, la carga recae en decisiones individuales, constantes y conscientes. Si las previsiones se cumplen, en menos de un año hasta el 90% del contenido en línea será producido por y con IA. Distinguir entre lo real de lo sintético dejó de ser un debate teórico. Hoy es una habilidad esencial para informarse, relacionarse y participar en la vida pública. Aceptar sin freno la basura generada por máquinas implica ceder el propio criterio sobre qué creer, qué ignorar y cómo actuar. Stop al slop es una condición mínima para no perder esa capacidad.

*Ph.D. en Ciencia Política de la Universidad de Turín (Italia). Ha sido docente e investigador de temas de comunicación política, periodismo y educación mediática e informacional. Miembro del equipo Educalidad.