Por: Alvaro Duque Soto*

El 19 de octubre de 2025, cerca de dos millones de jóvenes colombianos de entre 14 y 28 años elegirán sus Consejos de Juventud. Pocos días después, Colombia será sede de la Semana Mundial de Alfabetización Mediática e Informacional de Unesco, bajo el lema “Piensa ante la IA – AMI en el mundo digital”. Y el 2 de octubre, miles de docentes participarán en el “Día de la Inteligencia Artificial en tu colegio”, una jornada oficial para promover el uso crítico y ético de estas tecnologías.

Esta convergencia de fechas casi da para echar voladores. Pero también revela una grieta que vale la pena señalar: mientras la agenda pública sobre IA avanza a toda máquina, la experiencia de quienes conviven más intensamente con estos sistemas —los jóvenes— tiene escaso lugar en las decisiones que los afectarán durante décadas.

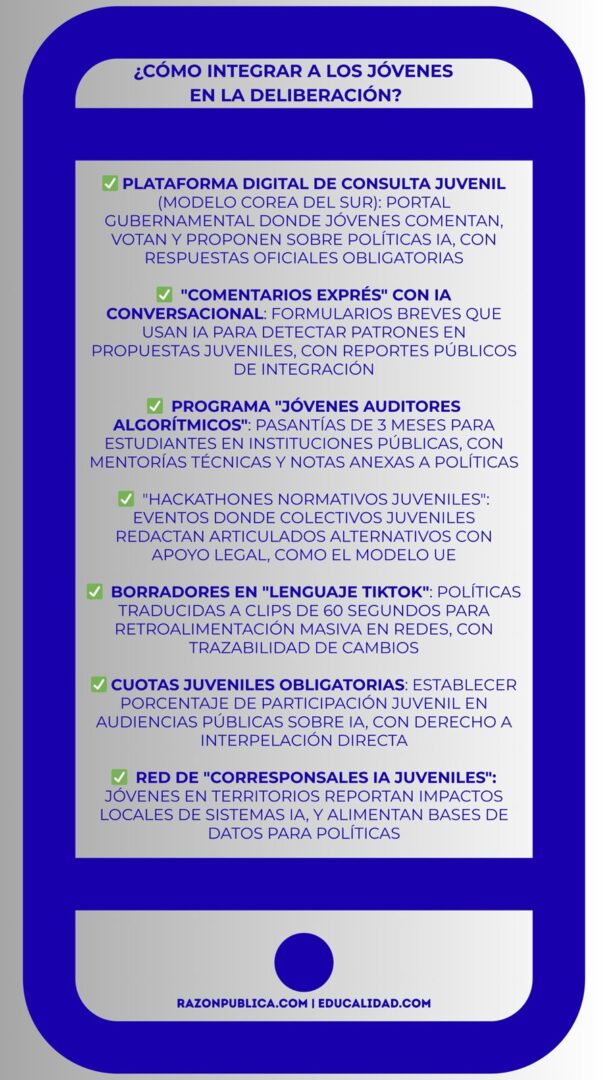

La Ley 2489 de Entornos Digitales Seguros abre oportunidades de participación en su implementación. Distintas iniciativas gubernamentales y de sociedad civil han intentado articular espacios de deliberación. Sin embargo, la perspectiva juvenil se incorpora tarde, de manera marginal y rara vez con poder decisorio real.

Esta exclusión tiene consecuencias que trascienden lo procedimental. En un ecosistema donde los algoritmos amplifican el desorden informativo —multiplicando falsedades, reforzando sesgos, silenciando voces—, regular sin escuchar a quienes conviven diariamente con estos sistemas profundiza un fenómeno preocupante: el desprendimiento cognitivo.

Este desprendimiento implica delegar el juicio crítico en tecnologías cuyo funcionamiento no comprendemos plenamente y normalizar la renuncia a pensar de manera autónoma. La pregunta entonces es: ¿Cómo podemos tomar decisiones informadas sobre tecnologías que redefinen por completo nuestras vidas si ignoramos sistemáticamente a quienes las habitan cotidianamente?

Entre el embrutecimiento y la lucidez

Entre los varios fantasmas que recorren hoy el mundo está uno que preocupa especialmente a los adultos: la IA está “embruteciendo” a los jóvenes. Los vuelve dependientes, distraídos, incapaces de discernir.

La visión no carece de fundamento. Sin mediación crítica, los riesgos cognitivos son reales: pérdida de atención, delegación del juicio, normalización de sesgos. Los riesgos sociales tampoco son menores: aislamiento, cámaras de eco que afectan la deliberación y la socialización. Y eso sin entrar todavía en lo que la IA oculta mientras dice mostrarlo todo.

También te puede interesar: https://razonpublica.com/detector-humo-desorden-informativo-11/

Pero hay otra historia, menos contada. En varios espacios juveniles ya existen formas intuitivas pero potentes de gobernanza digital. No son mayoritarias ni perfectas, pero están ahí y merecen ser parte del diseño de políticas. Veamos solo tres ejemplos que hemos documentado en el programa de Alfabetización mediática e informacional (Perami) en Educalidad.

- Auditoría crítica informal. En sus conversaciones cotidianas, muchos adolescentes ya cuestionan el sesgo de los algoritmos. Detectan cuándo una plataforma empuja contenido violento, cuándo un modelo repite prejuicios o cuándo un filtro refuerza estereotipos. No lo hacen con jerga técnica sino desde la experiencia vivida. Son auditores informales, sí, pero rigurosos a su manera.

- Traducción intergeneracional. Muchos jóvenes explican a sus padres y docentes cómo funcionan los sistemas digitales. Traducen términos técnicos, desactivan configuraciones invasivas, alertan sobre riesgos de privacidad. Ese papel mediador rara vez se reconoce institucionalmente.

- Experimentación democrática En comunidades como Discord, Reddit o incluso grupos de WhatsApp se ensayan microrreglas de convivencia: se eligen moderadores, se redactan códigos de conducta, se sancionan discursos de odio. Son laboratorios imperfectos, cierto, pero útiles para aprender cómo se gobiernan comunidades digitales.

Estas capacidades son valiosas pero frágiles y no caen del cielo: dependen de entornos que no siempre las apoyan. A menudo se pasan por alto porque conviven con dinámicas que nos sacan de quicio a docentes y padres: el acoso digital, la dispersión constante, la polarización que impide dialogar. Por eso urge integrarlas: convertir esa lucidez en insumo para la política pública.

Quiénes faltan en la mesa de decisiones

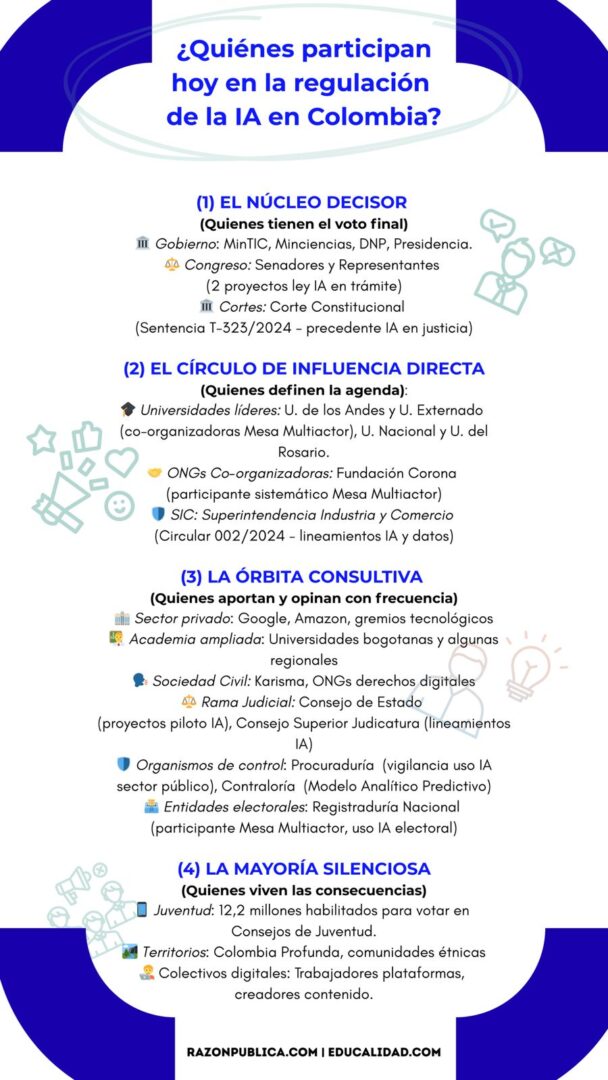

La Mesa Multiactor y el Foro de Gobernanza de Internet —con academia, Estado, sociedad civil y sector privado— han sido pasos en la dirección correcta. Sin embargo, persisten vacíos que limitan su representatividad.

La composición se concentra en capitales, universidades privadas y perfiles mayores de veinte años. Faltan territorios, colegios y voces de 14 a 18 que viven TikTok antes que seminarios y papers.

La brecha es territorial, socioeconómica, generacional y de género. La ausencia de mujeres —y especialmente de mujeres jóvenes— en estos espacios no es solo inequidad: empobrece el diseño de las normas.

Sin espacios que reconozcan esa diversidad, la regulación se escribe de espaldas a la experiencia y crece el riesgo de delegar decisiones en tecnologías que casi nadie entiende, y de aceptar sin revisión lo que sugieren.

La guía para regular el uso de dispositivos electrónicos en colegios presentada hace poco por Red PaPaz ofrece un ejemplo concreto: es un documento que no surgió de decisiones ministeriales unilaterales, sino del diálogo con estudiantes, familias y docentes en varias regiones. El proceso mostró algo que a menudo olvidamos: cuando los jóvenes participan en el diseño de reglas que los afectan, no solo las cumplen mejor, las mejoran, pues detectan problemas que a los adultos se nos escapan.

Ese aprendizaje debe trascender lo escolar. Si los jóvenes pueden cocrear reglas efectivas sobre dispositivos, también pueden diseñar políticas sobre algoritmos y privacidad digital. De otro modo, seguiremos regulando un ecosistema que conocemos peor que quienes lo habitan diariamente.

De los principios a la práctica: lo que aún falta

Colombia ha avanzado en reconocer la primacía de los derechos humanos en la regulación de IA, pero persisten tensiones. Los documentos gubernamentales ofrecen marcos éticos valiosos, concebidos desde arriba y con poca participación intergeneracional o regional. Se definen ‘supervisión humana’ y transparencia, pero se aplazan definiciones sobre vigilancia y sanciones que afectan a quienes estudian, crean contenido o buscan trabajo mediados por IA. La diversidad colombiana —cultural, territorial, etaria— puede convertirse en ventaja si se vuelve método: cocrear, pilotear y escalar con colegios, organizaciones juveniles y autoridades locales.

En América Latina, los países enfrentan dilemas similares: los marcos normativos de IA se diseñan copiando modelos de Europa y Estados Unidos que no encajan con nuestras realidades. Cuando los sistemas se piensan desde afuera, terminan por excluir las necesidades de comunidades indígenas, campesinas y afrodescendientes, cuyas formas de entender el mundo quedan invisibles en las decisiones sobre qué datos usar y cómo interpretarlos.

También te puede interesar: https://educalidad.com/educalidad-en-la-semana-de-la-ami

Pero claro que no es una cuestión sólo de la región. El reciente giro de Estados Unidos hacia una IA abiertamente proempresa, casi que sin contrapesos en derechos humanos o justicia social, muestra cómo regular la IA implica elegir entre derechos individuales versus bienestar colectivo, innovación versus protección, crecimiento económico versus equidad social. La carrera por el liderazgo tecnológico entre potencias puede marginar aún más a países como Colombia si no definen con claridad a qué valores dar prioridad y quién participa en esas decisiones.

El desprendimiento: cuando delegamos pensar

El problema no es solo técnico: también es epistemológico y político. La IA automatiza decisiones, convierte valores en algoritmos y da la impresión de actuar por sí misma, cuando en realidad sigue programas preestablecidos que presentan sus respuestas como si fueran naturales o humanas.

Aquí conviene hacer una pausa y plantearnos algo que no es poca cosa a la hora de establecer las reglas de la IA: ¿Qué nos hace humanos? Acertadamente, el filósofo Norbert Bilbeny lo formula de esa manera directa, y su pregunta puede servirnos de brújula frente a los discursos apocalípticos que afirman que la tecnología reemplaza nuestras habilidades en vez de potenciarlas.

Esta reflexión nos ayuda a evaluar si, en lugar de mejorar nuestras capacidades, la tecnología está debilitando aspectos fundamentales como la imaginación, la creatividad, la sociabilidad y el pensamiento crítico. A este posible deterioro lo llamamos desprendimiento cognitivo, un fenómeno que afecta no solo nuestra capacidad de pensar, sino también nuestras dimensiones emocionales, éticas y políticas.

El sector empresarial suele ordenar el debate en torno a cinco ejes —educación, gestión de riesgos, adopción, empleo y liderazgo organizacional—, todos relevantes desde una lógica productiva. Pero sin una pregunta anterior —cómo preservar lo humano en medio de la automatización— la discusión queda corta. La IA puede elevar productividad y abrir oportunidades; también puede vaciar de sentido el trabajo, la deliberación y la autonomía si no se gobierna con visión ética y participación plural.

De allí que las ciencias humanas y sociales deban recuperar su lugar no como adornos, sino como criterios operativos en la definición de políticas públicas: qué vale, a qué se da prioridad, qué límites no se cruzan, qué daños no se aceptan, aunque haya ganancia económica. Esas discusiones no pueden quedar reservadas a comités de expertos: deben incluir a quienes ya negocian cotidianamente su identidad con algoritmos.

Hay además una razón de oportunidad: el Congreso iniciará pronto el debate legislativo sobre IA, tras un mensaje de urgencia del Ejecutivo. Si esa discusión se acelera, tanto mejor; pero rápido no puede ser sinónimo de cerrado.

Una gobernanza que incluya, no que simule

Los jóvenes de hoy votan, crean y se comunican en un mundo moldeado por algoritmos, pero rara vez tienen voz en las decisiones sobre cómo se regulan esas tecnologías. Aunque existen espacios como consejos de juventud o foros educativos, falta lo esencial: incluirlos de manera real en la construcción de las normas que gobiernan los sistemas digitales. Esta exclusión reproduce el desprendimiento cognitivo del que hemos hablado: delegamos decisiones sobre tecnologías que no comprendemos plenamente, sin cuestionar a quién benefician ni a quién excluyen.

Colombia puede cambiar este panorama si construye una gobernanza que vaya más allá de enseñar sobre IA. Se trata de formar ciudadanos críticos, no consumidores pasivos, y de abrir las decisiones a quienes vivirán sus consecuencias durante décadas.

Si los jóvenes ya interactúan diariamente en entornos algorítmicos, ¿quién decide cómo se gobiernan esos algoritmos? Si dejamos que otros —o las propias máquinas— respondan por nosotros, el riesgo no será que la IA nos supere, sino que nos vacíe la capacidad de pensar y actuar por cuenta propia. La tecnología debe servir a la sociedad, no despojarnos de lo que nos hace humanos: la libertad, la creatividad y la responsabilidad compartida.

*Ph.D. en Ciencia Política de la Universidad de Turín (Italia). Ha sido docente e investigador de temas de comunicación política, periodismo y educación mediática e informacional. Miembro del equipo Educalidad.