Por: Alvaro Duque Soto*

Al final del día, muchos revisamos lo que nos dice ese juez digital que llevamos encima. Tal vez no alcanzamos los 10.000 pasos, la aplicación nos reprocha un nivel alto de estrés o el sueño resulta deficiente. Esos números, que parecen precisos y verificables, terminan orientando decisiones sobre dieta, ejercicio o descanso.

Esa supuesta base científica explica en parte el auge del mercado global de wearables —dispositivos electrónicos que se llevan puestos, desde relojes inteligentes hasta anillos de actividad y gafas conectadas—. En 2024 alcanzó un costo de US$125.000 millones, casi una cuarta parte del PIB anual de Colombia, con la venta de 538 millones de unidades en todo el mundo.

Sin embargo, esa confianza puede estar traicionándonos. Estos dispositivos contribuyen al desorden informativo (DI) en al menos tres frentes: producen métricas inexactas que distorsionan cómo percibimos nuestro cuerpo, nos venden expectativas irreales a través de marketing engañoso y exponen nuestros datos más sensibles a mecanismos poco transparentes de recolección, uso y comercialización, que generan nuevas formas de desinformación sobre la salud.

El fetichismo de los datos

Los wearables presentan sus métricas con números decimales, gráficas de colores y comparaciones temporales. Toda una estética que invita a confiar en ellos, muy parecida a la que vemos en las transmisiones deportivas de ciclismo, atletismo, fútbol y tantos otros deportes. Pero la realidad técnica es menos exacta.

Un estudio de la Universidad de Mississippi sobre los dispositivos más populares revela números inquietantes: la frecuencia cardíaca tiene un margen de error cercano al 4%, el conteo de pasos llega al 8% y el consumo de calorías —esa métrica que consultamos con obsesión— alcanza el 28%. En la práctica, cuando el consumo real está entre 1.400 y 2.550 calorías, el reloj puede mostrar un registro uniforme de 2.000.

También te puede interesar: https://razonpublica.com/detector-humo-desorden-informativo-2/

La medición del sueño resulta aún más imprecisa. Estos aparatos suelen sobreestimar el tiempo dormido en más del 10% y presentan errores que van del 12% al 180% frente a la polisomnografía, el estándar médico. La explicación es simple: miden movimiento con acelerómetros y asumen que la quietud equivale a descanso profundo, cuando podríamos estar despiertos, leyendo o mirando el teléfono.

La mayoría de los wearables tampoco ofrece garantías en parámetros como oxigenación sanguínea y presión arterial. De los modelos lanzados al mercado desde 2022, solo el 11% ha sido validado científicamente para al menos un indicador de salud. La precisión varía según la actividad física, la colocación del dispositivo, el sudor o el vello corporal. Además, los sensores ópticos tienden a fallar más en los tonos de piel oscura, lo que introduce un sesgo: las mediciones son más exactas para unos usuarios que para otros.

Estas limitaciones se relacionan con lo que varios investigadores llaman fetichismo de los datos, que es la tendencia a otorgar a las métricas cuantitativas un valor absoluto, casi mágico, sin considerar la intuición ni el conocimiento experiencial. Los usuarios de dispositivos de autoseguimiento suelen caer en la trampa de confiar ciegamente en cifras que, aunque precisas en apariencia, pueden ser engañosas.

Las consecuencias son concretas y están más cerca de lo que pensamos: personas que modifican su dieta, cambian rutinas de ejercicio o incluso se automedican con base en información inexacta o mal interpretada. Un ejemplo claro es el de los usuarios de relojes con monitores de fibrilación auricular, que experimentan mayor ansiedad y realizan más consultas médicas innecesarias debido a falsas alarmas.

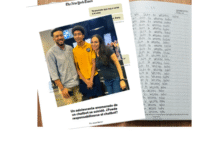

La neuróloga Suzanne O’Sullivan lo advierte en La era del diagnóstico: “El miedo a que nos diagnostiquen una enfermedad nos está llevando a someternos cada vez más a demasiadas pruebas, a acumular etiquetas y tratamientos innecesarios”. En otras palabras, los wearables refuerzan la obsesión por “¿y si estoy enfermo?” y nos mantienen en un estado de alarma constante ante posibilidades que, en la mayoría de los casos, nunca se materializan. Y así, cuanto más medimos nuestro cuerpo, menos lo escuchamos: hoy, muchos dudamos de nuestro propio bienestar si la pantalla no lo confirma. (Ver gráfico ¿Cómo aprovechar los wearables?)

La tiranía de los números y la culpa algorítmica

Los fabricantes de wearables no solo venden dispositivos: venden promesas. Frases como “Conoce tu cuerpo”, “Optimiza tu salud”, “Prevén enfermedades antes de que aparezcan” son el núcleo de un discurso que explota la jerga científica para comercializar productos sin respaldo real. Es lo que se llama scienceploitation, usar tecnicismos para dar apariencia de rigor, cuando en realidad los datos son poco fiables.

El ejemplo más claro es la meta de los 10.000 pasos diarios que mencionamos al inicio. Pocos saben de dónde surgió. No de la investigación médica, sino de una campaña de marketing japonesa en 1964 para vender podómetros: el llamado Manpo-kei (“medidor de 10.000 pasos” en japonés). Con el tiempo esa cifra, tan arbitraria como pegajosa, se convirtió en un estándar global, un caso de lo que podríamos llamar desorden normativo: la creencia de que solo al alcanzarla se asegura el bienestar.

Esa lógica de metas caprichosas no se limita a medir. También prescribe conductas. Las aplicaciones refuerzan este enfoque con notificaciones, sistemas de recompensas, comparaciones sociales que, en lugar de motivar, suelen generar culpa y frustración. Quienes registran cada detalle —desde una empanada hasta una gaseosa— pueden sentirse culpables por “fallar” en su dieta, mientras que otros se desaniman al ver que esfuerzos cotidianos —cargar bolsas, limpiar la casa o trabajar de pie— ni siquiera son reconocidos. Así, los wearables dejan de ser herramientas de apoyo para convertirse en jueces implacables que imponen reglas rígidas y castigan el incumplimiento.

El mismo estudio que analizó estas dinámicas en redes sociales señala también su impacto emocional. Muchos usuarios se sienten fracasados por no cumplir con los pasos diarios, romper una racha o desviarse de su plan alimenticio. “Si esto fuera un medicamento, estaría regulado. Pero al tratarse de ‘bienestar’, lleva más de quince años sin supervisión rigurosa”, afirman los investigadores, al advertir que la presión constante convierte la prevención en una obsesión donde el objetivo ya no es cuidar la salud, sino vivir en alerta permanente ante enfermedades que quizá nunca lleguen.

También te puede interesar: https://educalidad.com/educalidad-en-la-semana-de-la-ami

Las autoridades han comenzado a reaccionar: Fitbit fue multada en Australia por publicidad falaz y enfrenta demandas en Estados Unidos por funciones de monitoreo del sueño que no cumplen lo anunciado. En paralelo, países como Francia y España han implementado regulaciones para controlar a los influencers, al prohibir la promoción de productos de salud sin aval científico y exigir que el contenido manipulado sea claramente etiquetado. Sin embargo, estas medidas son insuficientes frente a un ecosistema saturado de contenidos engañosos que presentan los wearables como soluciones infalibles.

El efecto acumulado de promesas vacías, algoritmos engañosos y promoción tramposa es lo que se ha llamado patologización de la vida cotidiana. Nos convertimos en pacientes permanentes de nosotros mismos, atentos a dolencias que rara vez existen. Para quienes padecen trastornos alimenticios, estos aparatos pueden agravar conductas peligrosas, como el exceso de ejercicio o las dietas restrictivas. El problema, en todo caso, trasciende la tecnología.

Como se ha insistido desde la alfabetización mediática e informacional, es un asunto relacionado con una cultura que nos insta a medirlo todo, a superarnos siempre y evitar cualquier fallo. Los dispositivos no crean esa presión, pero la materializan al convertir cada dato en un veredicto sobre nuestro estilo de vida. (Ver gráfico Guía básica de supervivencia con los wearables).

Nuestro pulso vale

Pero hay un tercer problema, quizá el más dramático: los wearables transforman nuestra intimidad en mercancía.

Cada registro —ritmo cardíaco, patrones de sueño, ciclos menstruales, niveles de estrés— debería ayudarnos a vivir mejor. Sin embargo, en la práctica, nutre lo que Shoshana Zuboff llama “capitalismo de vigilancia”, un sistema donde empresas se lucran con nuestra información personal. A diferencia de la historia clínica, protegida por marcos legales estrictos que obligan a los sistemas de salud a guardar secreto profesional, las métricas de estos dispositivos circulan bajo estándares mucho más permisivos que permiten su transferencia a terceros y su almacenamiento indefinido.

La mayoría aceptamos esas políticas de privacidad sin leerlas porque están redactadas en lenguaje jurídico incomprensible e interminable. ¿Casualidad? Obviamente que no. Esa complejidad está diseñada para que no sepamos qué estamos autorizando. Por eso, varias regulaciones recientes buscan obligar a las empresas a ofrecer resúmenes cortos y claros que cualquiera pueda entender antes de aceptar.

Confiamos ingenuamente en que nuestros datos estarán protegidos. La realidad es otra: terminan en manos de aseguradoras que ajustan tarifas según nuestros hábitos, empleadores que condicionan beneficios laborales según nuestro perfil de salud, intermediarios o anunciantes que los explotan sin miramientos. Además, filtraciones masivas han expuesto millones de registros en internet, y perfiles supuestamente “anonimizados” pueden identificarse con 86% de precisión, a partir de patrones de comportamiento.

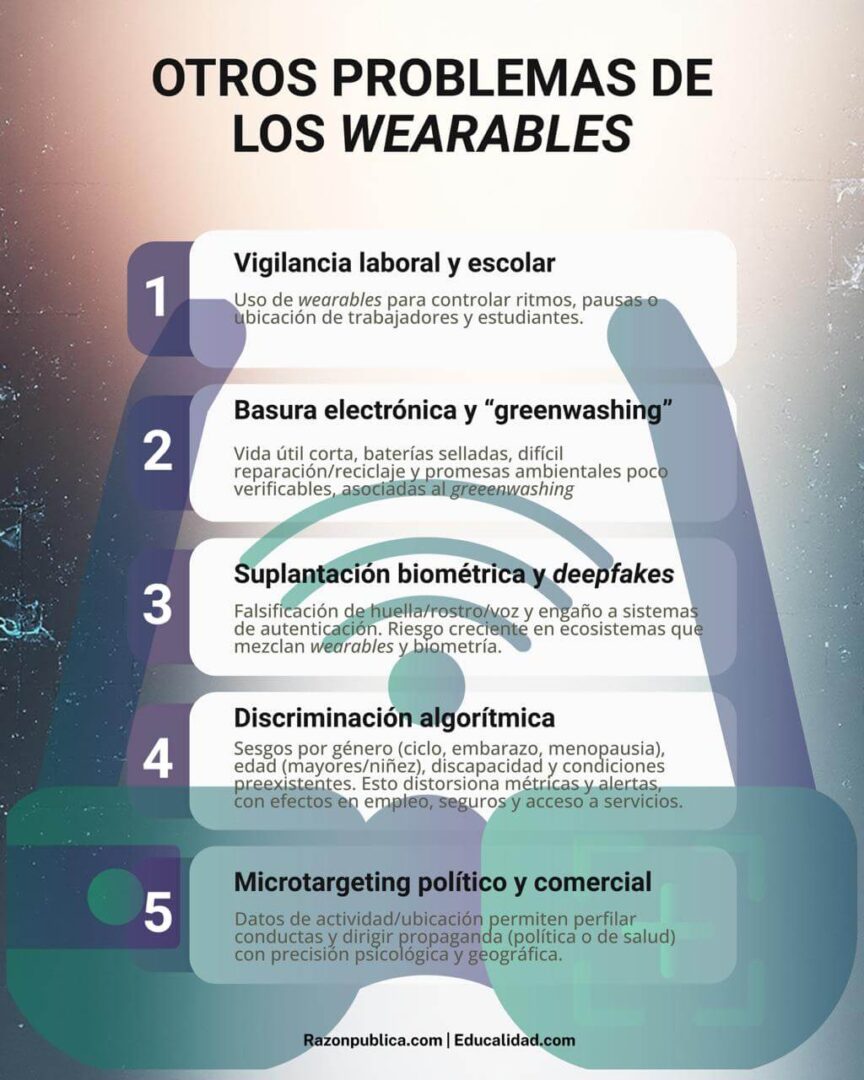

El riesgo se agrava con la procedencia de muchos dispositivos. Gran parte de los que usamos se fabrican en China, lo que ha desatado tensiones comerciales y de seguridad nacional en varios países. La preocupación no es solo ideológica: gobiernos autoritarios pueden acceder a información biométrica masiva de poblaciones extranjeras, un activo estratégico en conflictos geopolíticos donde los datos personales son moneda de cambio y herramienta de influencia. (Ver gráfico Otros problemas de los wearables).

Señores invisibles

No enfrentamos ya una vigilancia centralizada como la que imaginaron las distopías del siglo XX, sino algo más disperso y complejo: múltiples actores —empresas tecnológicas, aseguradoras, intermediarios de datos y, en ciertos contextos, gobiernos autoritarios— controlan fragmentos de nuestra información más íntima. No hay una autoridad única vigilando, sino una red de algoritmos que decide qué vemos, nos recuerda constantemente nuestras “fallas” y nos compara con estándares arbitrarios.

Como Josef K. en El proceso, de Kafka, luchamos contra una maquinaria invisible: ahora corporativa, algorítmica, que nos juzga sin palabras, solo con cifras. La batalla contra el DI también se libra en nuestra muñeca, que sabe demasiado y entiende poco. Y ese socrático ‘conócete a ti mismo’ exige hoy algo más: una conciencia crítica sobre la tecnología que elegimos dejar entrar en nuestras vidas.

*Ph.D. en Ciencia Política de la Universidad de Turín (Italia). Ha sido docente e investigador de temas de comunicación política, periodismo y educación mediática e informacional. Miembro del equipo Educalidad.